מה זה robots.txt ואיך הקובץ הזה עובד?

קובץ robots.txt מכיל הוראות לבוטים וזחלנים שאומרים להם לאילו דפי אינטרנט הם יכולים לגשת ולבצע סריקה ולאילו לא לגשת. קובץ robots.txt הם רלוונטיים מאוד למנועי חיפוש בכלל ולמנוע החיפוש בגוגל בפרט והשימוש בו יעזור למנוע החיפוש להבין אילו דפים אתם רוצים לסרוק באתר שלכם ואיזה דפים באתר לא ייסרקו. במאמר נדבר על קובץ robots, על השימוש בו, והחשיבות שלו לקידיום אורגני. אך קודם חשוב להבין מה זה קובץ robots.txt?

מה זה robots.txt?

קובץ robots.txt הוא קבוצה של הוראות עבור זחלנים ובטים. קובץ זה כלול בקבצי המקור שנמצאים ברוב אתרי האינטרנט. קבצי robots.txt מיועדים בעיקר לניהול פעולות של בוטים עם כוונה טובה (כמו מנועי החיפוש), אך הם לא צפויים להשפיע על בוטים זדוניים שלא מקשיבים להוראות הקובץ. תחשבו על קובץ robots.txt כמו קוד התנהגות בחדר כושר, חלק יקשיבו להוראות וחלק לא יקשיבו.

בוט הוא תוכנת מחשב אוטומטית המקיימת אינטראקציה עם אתרים ואפליקציות. ישנם בוטים טובים ובוטים רעים, זחלן של מנועי החיפוש הוא בוט עם כוונות טובות. הבוט הזה סורק דפי אינטרנט ומוסיף אותם לאינדקס כדי שיופיעו בתוצאות החיפוש. קובץ robots.txt עוזר לנהל את הפעילויות של סורקי האינטרנט הללו, כך שלא יעמיסו על שרת האחסון שלכם וימנעו אינדוקס של דפים שלא נועדו צריכים להיות באינדקס (דף תודה, מדיניות פרטיות וכו').

איך קובץ robots.txt עובד?

קובץ robots.txt הוא רק קובץ טקסט ללא קוד HTML (ולכן הסיומת שלו היא txt). קובץ רובוטס מאוחסן בשרת שלכם כמו כל קובץ אחר באתר וניתן לצפות בו על ידי הזנת ה-URL של האתר והוספה של robots.txt/. לדוגמא: https://www.easycloud.co.il/robots.txt

הקובץ אינו מקושר לשום מקום אחר באתר, כך שלא סביר שמישהו יתקל בו אלא אם כן ירשום את ה-URL המדויק שלו. רוב הבוטים הזחלניים של מנועי החיפוש יחפשו לסרוק את הקובץ הזה לפני שאר הקבצים באתר. חשוב לציין שאם יש לכם סאב דומיין באתר הוא צריך קובץ robots משלו. למשל: הקבצים הנפרדים https://www.cloudflare.com/robots.txt ו-https://blog.cloudflare.com/robots.txt.

קובץ robots.txt אמנם מספק הוראות לבוטים אבל הוא לא יכול לאכוף אותם. בוטים טובים של מנועי חיפוש ינסו למצוא את הקובץ כשהם מגיעים לאתר כדי לפעול לפי ההוראות. בוטים זדוניים יתעלמו מהקובץ robots.txt או יעבדו אותו כדי למצוא את הדפים שהגדרתם לא לסרוק באתר. הזחלנים שסורקים את הקובץ פועלים לפי ההוראות הספציפיות ביותר בקובץ, כך שאם הוא מכיל פקודות סותרות, הבוט הסורק יבצע את הפקודה המפורטת יותר.

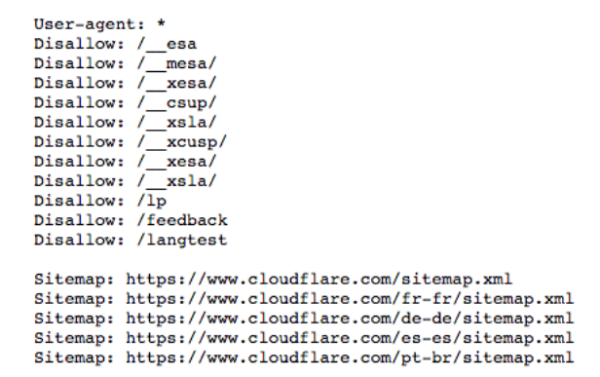

קבלו הצצה לקובץ robots.txt של Clodflare

פרוטוקולים ופקודות בקובץ robots.txt

פרוטוקול הוא פורמט למתן הוראות או פקודות. קבצי robots.txt משתמשים בכמה פרוטוקולים שונים. הפרוטוקול הראשי נקרא Robots Exclusion, זו הדרך לומר לבוטים מאילו דפים אינטרנט ומשאבים להימנע. באתרי וורדפרס הפרוטוקול הראשי כלול בקובץ. הפרוטוקול הראשי השני הוא פרוטוקול ה-Sitemap. בפרוטוקול זה, קבצי Sitemap מציגים לרובוט אילו דפים לסרוק וזה עוזר להבטיח שכל הדפים הרלוונטיים באתר שלכם ייסרקו

פקודות נוספות בקובץ robots

1. User-agent

מייצג הוראת סריקה לרובוט ספציפי. ב-user-agent נכתוב את שם הרובוט שאנחנו רוצים שיסרוק את האתר. ניתן לאפשר לכל הבוטים לסרוק את האתר על ידי סימון כוכבית ב-user-agent. פקודה זו מיועדת לאנשים שרוצים שרק מנועי חיפוש ספציפיים יסרקו את האתר שלהם.

בוטים נפוצים במנועי החיפוש שאותם ניתן להזין בקובץ robots.txt:

- Googlebot

- Googlebot-image (תמונות)

- Googlebot-news (חדשות)

- Googlebot-video (סרטונים)

- Bingbot

- MSNbot-media (תמונות וסרטונים)

- Baiduspider

2. Disallow

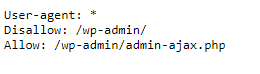

הפקודה הנפוצה ביותר בקובץ robots. הפקודה מסמנת לבוטים לא לסרוק דף, תיקייה או קבוצת תיקיות באתר או בשרת שלכם. דפים שהפקודה הזאת חלה עליהם לא בהכרח אסורים לא צפייה, הם פשוט לא רלוונטיים לגולשים (כמו פאנל הניהול של וורדפרס – wp-admin). ניתן להשתמש בפקודה Disallow במספר דרכים:

- חסימה של דף בודד – פקודת disallow לדף אינטרנט בודד מתבצעת כאשר שולחים קובץ עם הפקודה ולאחריו דף אינטרנט מהאתר. לדוגמא אם רוצים לחסום מסריקה את המאמר איך לעצור פניות ספאם בטופס צור קשר באתרי וורדפרס:

Disallow: blog/security-blog/contact-form-spam-in-wordpress/ - חסימה של תיקייה – לפעמים יהיה יותר יעיל עבורכם לחסום תיקייה של דפים מהאתר במקום לרשום את כל הדפים בנפרד. לדוגמא:

Disallow: /_file/ - הגישה פתוחה לכולם – פקודה זו בעצם אומרת שרובוטים וזחלנים יכולים לסרוק את כל החלקים באתר. הפקודה נראית ככה:

Disallow: - חסימה של כל האתר – ניתן בפקודה אחת בקובץ למנוע מכל מנועי החיפוש לחסום את כל הדפים באתר. הפקודה נראית ככה:

Disallow: /

3. Allow

הפקודה Allow היא בעצם הפקודה ההפוכה מ-Disallow. הפקודה אומרת לבוטים שהם רשאים לגשת לדף אינטרנט או ספרייה. פקודה זה עוזרת לכם לאשר לבוטים לסרוק דף או תיקייה ספציפיים בזמן שכל שאר הפקודות בקובץ מוגדרות ב-Disallow.

4. Crawl-delay

הפעולה הזו נועדה לעכב את הזחילה של הרובוטים על מנת להפחית עומס מהמשאבים בשרת. הפעולה מאפשרת לכם לציין כמה זמן הבוט הסורק צריך לחכות בין בקשה לבקשה, באלפית שניות. מנוע החיפוש של גוגל לא מזהה את הפעולה הזו, אך ניתן להגדיר אותה ישירות דרך ה-Search Console.

5. Sitemap

פרוטוקול מפת אתר עוזר לבוטים לדעת מה הסריקה שלהם צריכה לכלול. כדי להזין את הפרוטוקול בקובץ robots.txt עליכם לרשום: Sitemaps: ולאחר מכן להכניס את מפת האתר אותה ניתן למצוא ב-Google Search Console.

איך יוצרים קובץ robots.txt?

2 הדרכים היעילות ביותר ליצירת קובץ robots באתר שלכם הן בצורה ידנית ודרך כלי SEO. כדי ליצור קובץ רובוטס בצורה ידנית אתם צריכים לפתוח מסמך טקסט (כתבן) במחשב, להקליד את הפקודות הרצויות ולאחר מכן להעלות אותו לשרת או דרך תוסף. הקפידו ששם הקובץ נשאר robots.txt כשאתם מעלים אותו ושאתם מעלים קובץ אחד בלבד.

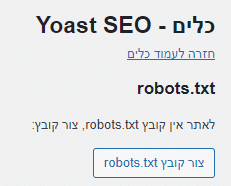

יצירת קובץ robots.txt דרך כלי SEO היא מאוד פשוטה. כדי ליצור קובץ כזה עם הכלי Yoast SEO לחצו על יואסט בתפריט בוורדפרס, לאחר מכן לחצו על עריכת קבצים ולבסוף לחצו על הכפתור צור קובץ robots.txt. בלחיצת כפתור הקובץ נוצר וגם עלה לשרת. כדי לבדוק אם יצרתם בהצלחה קובץ robots לאתר אתם יכולים לבדוק בכלי robots.txt Tester או לפתוח את הקובץ בדפדפן שלכם עם כתובת הדומיין שלכם ולאחר מכן להוסיף ל-URL את: /robots.txt

לסיכום

קובץ robots.txt הוא זה שאומר למנועי החיפוש לאילו דפים לגשת ולאילו דפים לא לגשת. שמירה על הפרטיות של חלק מהדפים באתר שלך ומניעת הסריקה שלהם היא חשובה ל-SEO ולקידום אתרים כי יש דפים באתר שלכם שלא צריכים להופיע ברשת החיפושים ואין שום סיבה שגולשים ייכנסו אליהם. הדפים הכי נפוצים הם כמובן התיקיות בפאנל הניהול (wp-admin), דפי תודה, דפים ללא תוכן, מדיניות פרטיות ועוד.

על הכותב

דביר נעמן, בן 26, יזם בנשמה, אוהב אתרי איקומרס ומתמחה בקידום אתרים.